L’intelligence artificielle fonctionne mais personne ne sait comment ni pourquoi, faute de fondements théoriques suffisants. D'autant que les pirates y ont également recours. D’où la nécessité d’une meilleure collaboration entre législateurs et scientifiques. En attendant, certaines armées créent des robots tueurs. Alors, à quand la version terroriste ou mafieuse ?

Analyse des signaux faibles, analyse comportementale, analyse de cible, reconnaissance de plaques minéralogiques, reconnaissance faciale… jusqu’ici, l’intelligence artificielle (IA) appliquée au monde de la sécurité s’est surtout développée dans la cybersécurité ainsi que dans les algorithmes d’analyse des images de vidéoprotection. Le secteur a le vent en poupe A l’échelle mondiale, le poids de la R&D dans le domaine de la sécurité et de la Défense représentent que 6% du total des investissements en IA, à égalité avec les FinTech et devant les RH, les loisirs ou les transports (3% chacun ), selon un récente étude du cabinet d’analyse européen Roland Berger. A présent, l’IA et ses systèmes auto-apprenants s’immiscent massivement dans les rouages des systèmes d’information les plus divers : voitures (bientôt autonomes), avions, engins de chantier, métros, tramways, systèmes de régulation de la circulation urbaine, robotique chirurgicale, lignes de production industrielle… La promesse est toujours la même : une automatisation des processus, une détection fine et accélérée des points d’intérêt, un accroissement de la qualité, de meilleures prises de décisions automatiques, etc. Or, en parallèle de l’éthique, il apparaît également important de se poser la question de la sécurité et de la sûreté de ces outils. Bref, faut-il confier notre sécurité à une intelligence artificielle ?

Détecter les anomalies

En cybersécurité, on roule sur du velours : les IA font leur travail et ne représentent pas de menace. La plupart d’entre elles enregistrent les utilisations « normales » d’un système dans le but d’élaborer un modèle de référence qui, par comparaison, permettra de détecter les anomalies, donc les attaques. Par exemple, InGen Security protège les sites internet en un temps record. L’opérateur de Security as a Service affirme, en effet, que son système WAF n’a besoin que de 5 minutes pour être 100% opérationnel. Son moteur d’IA apprend comment s’effectue le trafic des utilisateurs de confiance afin d’analyser les requêtes entrantes et les comparer aux requêtes « normales ». L’enjeu : bloquer le trafic des utilisateurs malveillants. Le système va alors générer automatiquement une politique de filtrage en auto-apprentissage et sans faux-positif. Cerise sur le gâteau, InGen Security avance que son offre permet, au passage, d’accélérer le site !

Dans le même esprit de comparaison à un modèle de référence, l’offre ICS CyberVision du français Sentryo est une plateforme de surveillance passive à deux niveaux, composée de sondes placées aux nœuds névralgiques des réseaux industriels et d’un logiciel central de visualisation et d’analyse de données. De quoi protéger une usine, une ligne de métro ou une centrale nucléaire. Le système identifie d’abord les vulnérabilités du réseau Machine-to-Machine en constituant une cartographie numérique des flux de données pour comprendre la topologie du réseau industriel et son fonctionnement. Une fois le modèle de référence établi, l’accès à l’historique de fonctionnement du réseau permet d’identifier la cause d’une attaque. Interviennent alors les ingénieurs de cybersécurité pour analyser et contrer le problème. Précisons que Sentryo prend en charge non seulement les infrastructures informatiques industriels mais aussi l’Internet des objets (IoT). De son côté, le Laboratoire des systèmes communicants du CEA-List va plus loin avec ses sondes actives de détection des cyber-intrusions. Au lieu de se contenter « d’écouter » le trafic de données, elles font preuve d’une intelligence de groupe. Grâce à des réseaux de neurones implémentés sur des nano-PC, elles auto-gèrent et sont capables de travailler en équipe automatiquement, comme une patrouille de police.

Difficile de certifier une IA

Mais l’IA ne se contente pas de la cybersécurité. Et, pour l’heure, il n’existe pas de loi sur l’IA. Jusqu’ici, l’arsenal juridique français s’appuie sur la loi Informatique et Libertés qui interdit qu’une machine puisse prendre des décisions pouvant avoir des « conséquences cruciales pour les personnes ». Cependant, les algorithmes déterministes des métros automatiques de la ligne 14 et de la ligne 1 à Paris, comme les automates industriels de fours sidérurgiques ou des stations de production d’eau potable, prennent tous les jours des décisions pouvant impacter la sûreté de l’environnement industriel ou la santé des citoyens. Plutôt sûrs, ces codes sont audités, testés et certifiés conformes par des bureaux de contrôle qui ont pignon sur rue.

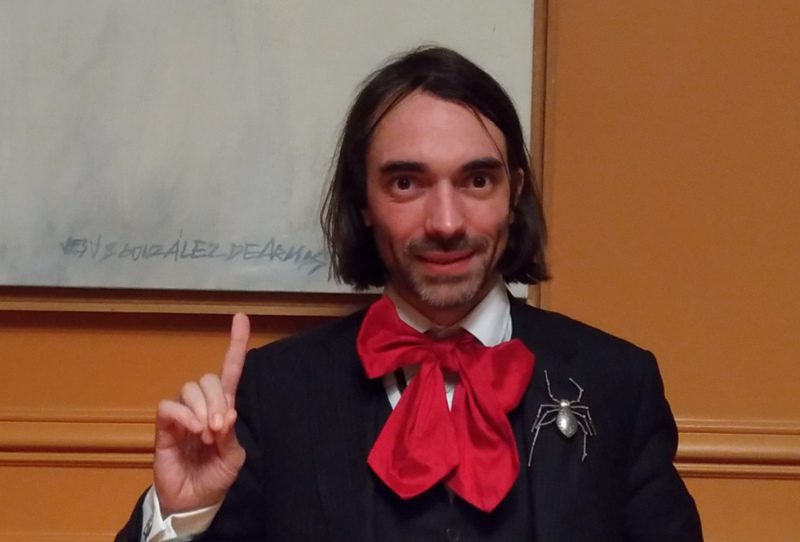

Cependant, il n’en va pas de même pour les algorithmes auto-apprenants de Machine Learning et de Deep Learning. « L’IA s’est développée de manière empirique : ça marche mais on ne sait pas comment ni pourquoi. Nous ne savons même pas pas quels sont les vrais concepts théoriques qui sous-tendent l’IA », reconnaît Cédric Vilani, chercheur en mathématique (Médaille Fields 2010), député (LREM) et vice-président de l’Office parlementaire d’évaluation des choix scientifiques et technologiques (Opecst), chargé par le gouvernement de la mission Intelligence artificielle (IA) dont le rapport a été rendu le 28 mars dernier. En matière de sécurité et de sûreté de fonctionnement des systèmes, on manque également d’experts disposant d’une solide connaissance globale des technologies d’intelligence artificielle ou des problèmes que pose leur implémentation.

de l’Opecst, chargé par le gouvernement de la mission Intelligence artificielle (IA). © TCA-innov24

Des dangers d’une nouvelle espèce

Dans l’étude « The Malicious Use of Artificial Intelligence : Forecasting, Prevention, and Mitigation » publiée conjointement par Future of Humanity Institute, l’Université d’Oxford, le Center for the Study of Existential Risk, l’Université de Cambridge, le Center for a New American Security, Electronic Frontier Foundation et OpenAI, l’analyse des scientifiques invite à la prudence. Certes, l’IA pourrait contribuer à tailler dans les coûts du traitement des cyberattaques en automatisant des tâches qui réclament de l’intelligence ou de l’expertise humaines. Mais l’IA est également utilisée « pour rendre les attaques existantes bien plus difficiles à contrer ou à déceler », soulèvent les scientifiques qui pensent à la synthèse d’image pour truquer les vidéos ou encore à la synthèse vocale pour cacher des attaques de phishing et d’ingénierie sociales sans cesse plus difficiles à identifier.

Pourrons-nous contrôler les robots tueurs ?

Les chercheurs américains et britanniques évoquent aussi le couplage de l’intelligence artificielle à des drones ou des robots désormais capables de conduire des attaques physiques automatiques. De fait, l’IA embarquée confère aux robots mobiles un degré plus ou moins élevé d’autonomie. En revanche, plus l’autonomie augmente, plus graves sont les dégâts qu’une personne mal intentionnée pourrait occasionner. En l’absence de réglementation internationale, certaines armées développent même des robots tueurs. En tête, les Etats-Unis où le Département de recherche militaire américain (Darpa) dispose d’un budget de 15 milliards d’euros pour le seul développement des robots militaires, selon le New York Times. Des drones autonomes capables de déterminer quelle cible attaquer « sans aucune aide humaine » sont d’ailleurs en phase de test. Côté russe, le robot humanoïde Fedor (Final Experimental Demonstration Object Research), révélé il y a deux ans, sait tirer sur des cibles avec deux pistolets. Chine, Israël, Inde, France et Corée du Sud sont également sur les rangs… Ainsi, grâce à son système de tracking, le robot tueur coréen SGR-A1 de Samsung détecte-t-il les intrusions sur un rayon de quatre kilomètres. Implanté au poste-frontière, cet automate prend lui-même la décision de tirer sur ce qui s’approche : une personne comme un véhicule. Équipés d’une mitrailleuse, d’un lance-grenades, de capteurs de chaleur, de caméras de détection infrarouge et d’une intelligence artificielle, plusieurs de ces robots sont déjà installés depuis trois ans sur la zone démilitarisée entre les Corée du Nord et du Sud. Un jour ou l’autre, de semblables robots pourraient bien se retrouver aux mains de mafieux, trafiquants, terroristes et autres pirates…

Collaboration nécessaire entre chercheurs et législateurs

Depuis 2012, Human Rights Watch coordonne 51 organisations non gouvernementales pour dénoncer le développement de ces engins dans le cadre de la campagne internationale Stop Killer Robots (en français, « Arrêtez les robots tueurs »). Le 4 avril dernier, des experts en IA et robotique provenant d’une trentaine de pays ont alerté l’opinion au sujet du Korean Advanced Institute of Science and Technology (KAIST) qui vise à développer des armes autonomes pour la société Hanwha Systems. De leur côté, les chercheurs américains et britanniques du rapport « The Malicious Use of Artificial Intelligence : Forecasting, Prevention, and Mitigation » insistent sur une plus grande collaboration entre législateurs et chercheurs en IA afin de comprendre les rouages et les implications de ces technologies. De même, ils invitent les chercheurs à mieux analyser les implications potentiellement malveillantes de leurs technologies et à en limiter les impacts.

Erick Haehnsen

sur un rayon de quatre kilomètres.

CC Mark Black Ultor

Commentez